O maior vitorioso da noite passada não foi Barack Obama, reeleito para a Presidência dos EUA numa eleição cara e apertada, com 303 dos 538 votos eleitorais.

O maior vitorioso foi um nerd de dados de 34 anos, fã de estatísticas de beisebol, chamado Nate Silver. Filho de um cientista político e de uma ativista comunitária, com rigorosa formação em estatística, ele mantém no New York Times um blog de análise política com dados chamado FiveThirtyEight.

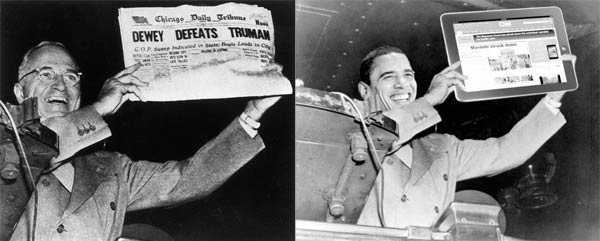

Pela segunda vez, Silver previu com precisão a vitória de Obama em todos os Estados.

Neste ano, pela visibilidade que lhe foi dada pelo New York Times, suas previsões sofreram uma série de ataques dos analistas políticos tradicionais, que focam mais nas movimentações de bastidores do que na numeralha. No dia 29, um dos analistas de corridas de cavalos citados pelo site “Politico” declarou que Nate Silver seria uma “celebridade de um só mandato“.

Na noite da eleição, num videocast do New York Times, a apresentadora perguntou a Silver como era possível ele dizer que Obama tinha mais de 90% de chances de vencer, se as pesquisas nacionais apontavam Romney à frente. Silver explicou um pouco de seu modelo estatístico: ele calcula uma média ponderada das pesquisas dos Estados como base do modelo. Diferente do Brasil, lá o candidato precisa ganhar em cada Estado, pois cada Estado tem seus votos eleitorais. As pesquisas nacionais, então, podem dar erro facilmente.

Em entrevista a Tim Harford, da BBC, em outubro, Silver detalhou um pouco mais o seu modelo. Ele utiliza o teorema de Bayes para ajustar as probabilidades aos novos fatos que vão surgindo – no caso, as novas pesquisas. Bayes trata de probabilidades condicionais: a chance de algo acontecer versus a chance de o seu contrário acontecer. Leva em conta os falsos positivos e falsos negativos também.

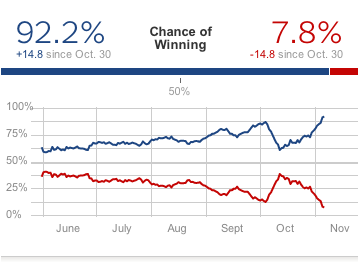

Assim, quando Silver dizia que Obama tinha 86% de chance de vencer, não queria dizer que ele teria 86% dos votos, e sim que, caso fossem simuladas 100 eleições, em 86 delas Obama teria mais da metade dos votos eleitorais. Nas outras 14, Romney tinha chance de ganhar. No dia anterior à eleição, Silver dava mais de 90% de chance de Obama ganhar.

Ainda que Romney tivesse ganho, isso estava dentro das probabilidades. Mas a maior chance era de que Obama ganhasse. E foi o que ocorreu. Vale a pena ler o live blogging que Silver fez.

DOIS TEMPOS, DOIS LIVROS

O primeiro estatístico que se tornou famoso por criar um modelo matemático para tentar prever o resultado de eleições foi Ray C.Fair, professor de Yale.

No livro “Predicting Presidential Elections and Other Things“, publicado em 2002, Fair explica como criar um modelo econométrico para prever uma eleição. Segundo ele, o fator preponderante para uma vitória eleitoral é a saúde da economia. Assim, seu modelo leva em conta quem está no poder, os resultados de eleições antigas, a taxa de crescimento da economia, a taxa de inflação, o número de trimestres de boa economia. A análise era basicamente de regressão, e não levava em conta as pesquisas de intenção de voto.

O modelo de Fair funcionou bem para torná-lo o mais famoso guru de previsões políticas dos anos 80. Seu modelo, que olha para o passado, previu quem venceria as eleições de 1980, 1984 e 1988. Errou em 1992 e 1996. Seu livro, de 2002, sugere que Bush ganharia em 2004, o que realmente ocorreu. Mas Fair acabou comendo poeira no mercado de previsões.

Se você leu o livro “Os números (não) mentem“, de Charles Seife, que eu resenhei aqui recentemente, poderá ler um bom trecho sobre por que Fair errou. “A equação de Fair é um modelo sofisticado para encontar padrões nos dados, mas o padrão era praticamente sem sentido”, diz Seife.

Nate Silver, por sua vez, deixa de lado o passado e olha o presente. Ele começou a fazer previsões com o beisebol, em 2003, quando criou um modelo para prever campanhas de times a partir das estatísticas de cada campeonato – mais ou menos como na história contada em “Moneyball” (também escrevi a respeito outro dia).

Ele também escreveu um livro muito interessante, que estou lendo devagar: “The Signal and the Noise“, ainda não publicado no Brasil. Nele, Silver dedica o capítulo 2 a descrever como criou a parte básica do seu modelo. E começa já de cara zoando monumentalmente os analistas de corrida de cavalos.

Ele coletou mil “previsões” feitas pelos analistas convidados para o programa de TV “The McLaughlin Group” sobre todo tipo de assunto e checou quantas deram certo e quantas deram errado. Deu exatamente meio a meio – ou seja, jogar uma moeda para o alto daria uma previsão tão precisa quanto as dos analistas tradicionais. “The McLaughlin Group, é claro, é mais ou menos explicitamente feito como comédia pastelão para viciados em política”, ele diz.

(Talvez por esse senso de humor os “pundits” americanos atacaram Silver com tanta força nas semanas antes da eleição. Assim como os analistas tradicionais de esporte atacaram com força os métodos estatísticos usados pelo técnico Billy Beane para levantar seu time.)

Silver retoma uma pesquisa de Philip Tetlock (do livro “Expert Political Judgment”) e observa o quanto estar preso ao passado dificulta a análise do presente e a previsão do futuro. Certezas como “nunca um candidato X venceu quando Y”, análises favoritas dos pundits tradicionais, só se mantêm até a primeira vez em que isso acontece. Melhor análise a respeito dessa lógica é a da tirinha XKCD (clique aqui).

O problema, segundo Silver, é que os especialistas tradicionais conhecem tão bem o passado que tendem a construir narrativas muito bem-amarradinhas em sua cabeça e não enxergam o que Nassim Nicholas Taleb chamou de cisnes negros.

“Quando construímos essas histórias, podemos perder a capacidade de pensar criticamente sobre as evidências”, escreveu Silver em seu livro. Mas a vida, enfim, é feita de incertezas – e foi por esse tipo de previsão do passado que os especialistas políticos não conseguiram antecipar o colapso da União Soviética e outros fatos importantes.

(Mais ainda: no primeiro capítulo de seu livro, Silver observou que foi a certeza de que os preços de imóveis subiriam para sempre, ao invés de ser uma bolha que poderia estourar a qualquer momento, que derrubou a economia americana. A certeza de aumento eterno, ultimamente, mudou-se dos Estados Unidos para o Brasil. Vai ser feio quando estourar.)

Um dos motivos para as previsões darem tão errado, diz Silver, é a forma como se cobre política tradicionalmente. Quando há um debate, por exemplo, todos analistas querem ser o primeiro a declarar “quem ganhou”. No último debate municipal da Globo, logo antes da eleição, tanto os aliados de Haddad quanto os de Serra diziam que o seu candidato “ganhou” o debate. A Raquel Cozer, da coluna “Painel das Letras”, observou bem em seu Twitter: se os dois ganharam, então o César Tralli perdeu.

Nate Silver crava: “há uma obsessão em determinar qual candidato ‘ganhou o dia’, com alguma frase feliz numa entrevista coletiva ou por ganhar o apoio de algum senador obscuro – coisas com as quais 99% dos eleitores não se importam”. Da cobertura, ele diz, “a maior parte é tapa-buraco, empacotado na forma de matérias feitas para obscurecer sua desimportância. A cobertura política não apenas perde fácil o sinal – frequentemente, ela acentua o ruído”.

Pense em todo o noticiário sobre um candidato xingando o outro, por exemplo. Ou na “guerra santa” que tivemos em São Paulo.

Foi aí que Silver criou seu modelo. Ele tem estes três princípios:

1. Pensar probabilisticamente. “Ao invés de apenas cuspir um número e dizer que sei exatamente o que vai acontecer, prefiro articular uma faixa de resultados possíveis”, escreve. Se um candidato tem 75% de chances de vitória, tem 25% de chances de derrota. “Torcedores políticos, porém, podem interpretar mal o papel da incerteza numa previsão; eles julgarão que isso é criar uma desculpa para o caso de sua previsão dar errado. Essa não é a ideia”, diz. “A marca de uma boa previsão é que cada uma das probabilidades esteja razoavelmente certa no longo prazo”.

2. A previsão de hoje é a primeira previsão do resto da sua vida. Ao longo de uma campanha, o resultado se torna mais previsível e as previsões ficam mais estáveis. Um bom modelo, diz Nate Silver, deve ser atualizado conforme novos fatos forem aparecendo. Por isso ele usa o teorema de Bayes.

3. Procure o consenso. As pesquisas variam muito entre si. O autor, assim, afirma que o agregado das pesquisas é mais preciso do que as pesquisas individuais. Ele recomenda cautela com previsões tipo “bala-de-prata”, que saem muito longe do consenso. Ele também pondera os resultados frios das pesquisas com outros dados.

No calor da eleição, Nate Silver propôs uma aposta a um comentarista da MSNBC. Foi no Twitter: se Obama vencesse, o comentarista daria mil dólares à Cruz Vermelha. Se Romney vencesse, Silver daria mil dólares à entidade.

Não sei se Joe Scarborough topou a aposta. Mas a Cruz Vermelha merece essa grana.